記事執筆の背景

「AIは間違う」という前提と、それでも使われる理由

生成AIの普及に伴い、「AIは万能ではない」「AIは間違うこともある」という認識は、ある程度社会に浸透してきました。しかし実務の現場では、その「間違う可能性」を理解しながらも、多くの企業がAIを導入し続けています。これは、AIが持つ圧倒的な処理速度と情報の広がり——つまり「人より速く」「人より広く」情報を扱える能力が、誤りのリスクを上回る価値を生んでいるからです。

しかし、この「リスクと効率のトレードオフ」をどう扱うかは、もはや個々のユーザーの判断だけに委ねられる問題ではなくなりつつあります。

企業、行政、教育機関——社会全体がAIを前提として動き始めた現在、「AIを使うこと自体の合理性」が法的・倫理的に問われる段階に入っているのです。

本記事では、経済産業省が主催する「AI利活用における民事責任の在り方に関する研究会」の議論を手がかりに、AI活用に伴う注意義務の範囲と、その背後にある構造的な問題を整理します。

「人間が確認してください」注記への不満が法的に議論されている

生成AIを実務で使う際、多くのユーザーが感じる最大のストレスは、「AI出力を人間が逐一確認し、その結果に責任を取らなければならない」という社会的要請にあります。

企業で生成AIを活用する場面——契約書のドラフト作成、大量の文書要約、顧客対応の自動化——において、その出力をすべて人間が確認することは、現実的ではありません。もし毎回確認が必要なら、「人より速く」「人より広く」処理できるというAIの最大の利点が、確認作業によって相殺されてしまいます。

この問題は、技術進化によってさらに深刻化しています。初期の生成AIは、プロンプトエンジニアリングやRAG(検索拡張生成)を駆使して人間が細かく指示を出しながら使うものでしたが、近年MCP(Model Context Protocol)などの技術発展により、AIの自律的な稼働が可能になりつつあります。技術は自律化に向かっているのに、法的責任は依然として人間に集中している——この矛盾が、現場のストレスを生んでいるのです。

生成AIを使用する場合の責任論:個別判断の要否

原則としては利用者の個別判断が必要

生成AIを使用する以上は、原則として利用者が責任を負う——この考え方は、今後も法的な基本原則として維持されるだろうと考えられます。

この原則は、生成AI特有のものではありません。自動車や機械設備など、他の技術領域でも同じ考え方が貫かれています。生成AIは、一つのアルゴリズムであり、道具です。それを使う人間が、依然として一次的な責任を負う——この構造は、技術がどれほど高度化しても変わらないでしょう。だからこそ、「AI出力を人間が確認してください」という原則的な注意義務が発生するのです。

法律には「報償責任」という考え方があります。これは、自分一人ではできないことを、他人や道具を使って実現し、その結果として利益を得る場合、それに伴うリスクや危険も自分が負うべきだという原理です。生成AIの活用も、まさにこの構造に当てはまります。

AIを使うことで、人間は自分の行動範囲や意思決定能力を大幅に拡張できます。大量の情報を瞬時に処理し、複雑な文書を短時間で作成し、多様なタスクを自動化できる——これらはすべて、利用者が得る利益です。であれば、その利益に伴って増加するリスクや危険も、利用者が責任を負うべきというのが、法的な基本的な考え方となります。

個別判断を避けるための「合理性」と「統制システム」

生成AIの出力に対してユーザーや利用者が個別判断を行うというのが原則だとしても、個別判断がそもそも適さない場合や、個別判断を避けたい場面というのも、自律的なAIの登場によってますます出てきています。

一つは、大量のデータや出力をAIが行うことで、個別判断自体がもう現実的ではなく、個別判断をしてしまうとせっかくのAIの利便性を損ねてしまうような類型です。

もう一つは、連続的・継続的な運用が行われている類型で、たとえば議事録を要約するAIがあります。人がいちいち音声を確認したり、議事録の要約内容が適切かどうかを確認するというのは、正直ボトルネックになります。こうした場面は、個別判断を避けたい典型例と言えるでしょう。

また、実行する速度が速すぎて人間による確認を行えない、いわゆる作業を止めてはいけないスピード重視の場面も考えられます。

このように個別判断を避けたい場合には、当然何かしらのニーズがあるはずです。

私の私見ですが、その個別判断を回避する生成AI使用に対する合理性の度合いと、そのAIをいかに制御するかという統制システムとの運用面のバランスが、一つの責任判断の重要な要素になってくるのではないかと考えています。つまり、個別判断を避けるべき合理的な理由があるのであれば、避けてもよいが、本来個別判断をすべきだったのだから、個別判断をした時と同視できるようなシステム設計や運用を行うことで、個別判断を行っていると評価しようといった具合です。

弁護士が生成AIで訴状を大量に作成し裁判所に提出できるか?

例えば、個別判断を避けるような生成AI導入の必要性があまり高くないのに導入しようとしている場合は、しっかりした統制システムを用意していたとしても不十分だと思われます。

具体例を挙げると、弁護士が訴状の作成で生成AIを使って高速大量に出力を行い、弁護士の確認を行わずに裁判所に訴状を提出できるかという問題を設定した場合、結論としては「できない」となるでしょう。その理由は、個別判断を不要にしたいというところの合理性がないからです。弁護士という専門資格業は、その人間の属人的な能力や最終的な確認というところに重要性があるという仕組みで成り立っています。個別判断を行うということが、弁護士の訴状提出や代理人としての業務において中核を占めているわけです。それを完全に外すことはできませんし、仮に訴状の作成を生成AIが行い、それを弁護士が確認するというシステムを構築しようとした場合でも、統制システムにはかなり高度なシステム構築が必要になってくると思います。なぜ高度なものが必要になるかというと、導入の合理性が基本的には難しいところにあるからです。「難しい」というのは、弁護士の中核たる意思決定、つまり個別判断の部分が中核を占めているという資格との関係での話です。

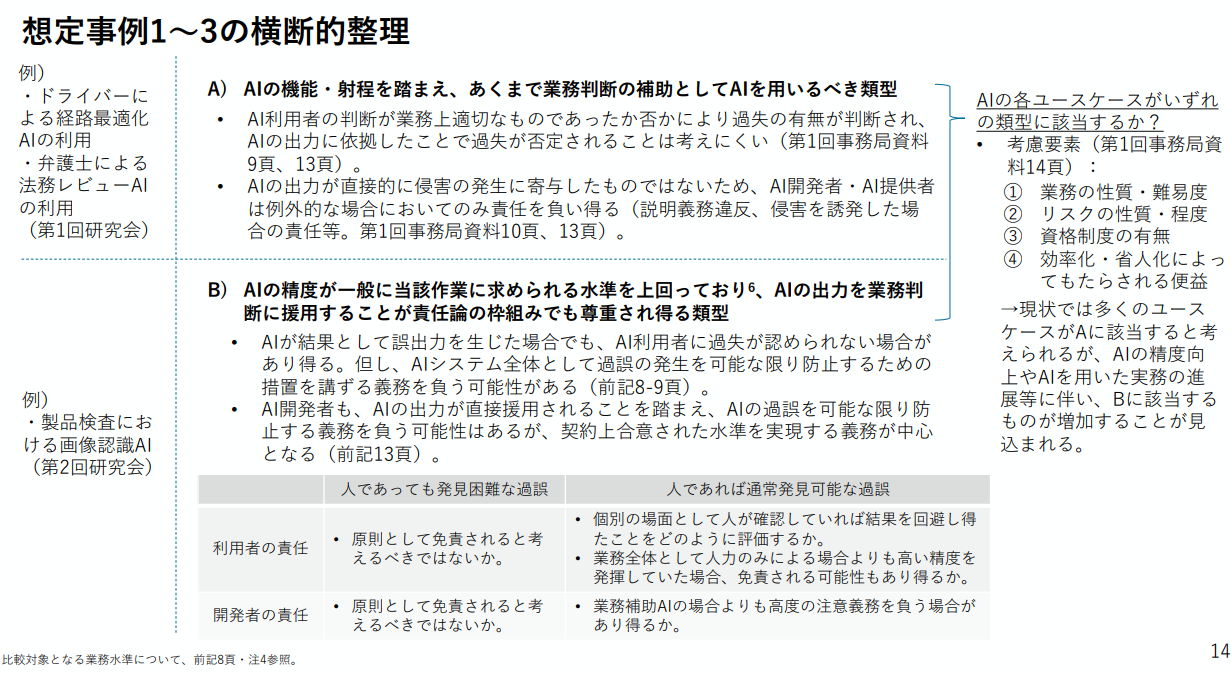

経済産業省の資料では、生成AIの出力が一般人の平均的な水準を超えるか超えないかというところを一つのファクターにしているように見えますが、私個人としては切り分ける基準として考えるより、グラデーションのような一つの要素としてとらえる方が良いように思います。

というのも、生成AIの出力が悪くても、個別判断を使わない方向で運用するということは十分ありえるからです。モデルは成長していきますし、運用の改善によってその後人間的なものを超えるとか、他のいろんな狙いもあると思います。生成AIの出力が一般的な平均的な人間を超えるか超えないかという基準というよりは、単純に導入の合理性や導入場面を見て、それに対する統制システムの構築と運用がどのように行われているかというところで、過失の責任判断を行っていくのが良いのではないかと考えています。

お天気情報を収集して整理する生成AIに個別判断は必要か?

別の例として、天気予報を通知するサービスを考えてみましょう。生成AIが全国の、あるいは全世界の都市の天気を取得して、Function Callingなどで検索を行ってデータを取得し、これをユーザーに提供するという場面を想定します。この場合、たとえば東京の天気が本当に晴れか雨かというのを人間が個別判断するわけにはいきません。これは大量データだから個別判断するのが非合理的だというところもありますし、スピードが重要だから人間の確認を挟んでいるとボトルネックになってビジネスが止まってしまうという点からも、それなりの必要性、つまり個別判断をスキップするという合理性はあるでしょう。それに対する統制システムは、先ほどの弁護士の例とは違って、きちんとしたアセスメント——AIがたとえばFunction Callingで適切なURLから天気情報を取得してくるかどうか、取得した天気情報に対して改変を加えないようなプロンプトになっているかどうか、といったところがすごく重要になってきます。先ほどの弁護士の例との違いは、個別判断を避ける理由と避けたとしても避ける前と同視できるかという点で、弁護士は同視できず、お天気は情報の取得が要点なので同視できる仕組みが思いつきやすいという点が異なります。

まとめ:生成AI利用における責任の新しい枠組み

生成AIの出力をそのまま信頼することには、依然としてリスクがあります。

そのため、「出力を人間が確認する」という注意義務の原則は、今後も完全には失われないでしょう。

しかし、生成AIの利用領域が拡大し、その自律性が高まるにつれて、人間による個別判断だけでは統制しきれない領域が増えていることも確かです。

こうした中で、求められるのは「AIの誤りを完全に防ぐこと」ではなく、「誤りを前提として合理的にリスクを低減できる仕組みを構築すること」です。

つまり、注意義務の関心は“確認”から“設計”へと移りつつあります。

生成AI時代の注意義務は、もはや「AIを使うな」でも「AIを信じるな」でもありません。

重要なのは、AIの特性と限界を理解し、どのように信頼し、どのように制御するかを設計する責任を、社会全体が共有することだといえそうです。